معرفی مدل M4 با توانایی ترجمه ماشینی زبانهای کممنبع

نتایج تحقیقات گوگل درباره ترجمه ماشینی زبانهای کممنبع (که گویشور کمی دارند و از آن بدتر متون دوزبانه زیادی برای آنها وجود ندارد) برای علاقهمندان این حوزه شگفتانگیز است. با استفاده از مدل M4 امروزه میتوان مدلهای نورونی را به صورت ترکیبی از چند زبان آموزش داد، یک مدل را با چندین و چند زبان آموزش داد و از زیاد بودن دادههای یک زبان به نفع زبان دیگر که ورودیهای آن محدودتر است استفاده مثبت کرد. شما را به مطالعه ترجمهای از مطلب انتشار یافته در وبلاگ هوش مصنوعی گوگل دعوت میکنیم:

آنکور باپنا، مهندس نرمافزار، و اورهان فیرات، پژوهشگر، مرکز تحقیقات گوگل

در سالهای اخیر، کیفیت سیستمهای ترجمۀ ماشینی (MT) پیشرفت زیادی کرده و، به مدد پیشرفتهای ایجادشده در ترجمۀ ماشینی عصبی (NMT)، سدهای زبانی در سرتاسر دنیا فرو ریخته است. با این حال، موفقیت NMT تا حد زیادی مدیون حجم بالای دادههای آموزشی تحت نظارت است. اما، درمورد زبانهایی که دچار کمبود داده هستند یا حتی داده ورودی چندانی برای آموزش ندارند چه باید کرد؟

یکی از راهحلهای احتمالی NMT چندزبانه (Multilingual NMT) است. مدل NMT چند زبانه بیان میکند: «نشانۀ یادگیری مدل از یک زبان باید به کیفیت ترجمه به زبانهای دیگر کمک کند» این گفته نوعی بایاس استنتاجی است (Inductive Bias).

ترجمۀ ماشینی چندزبانه چندین زبان را با استفاده از یک مدل ترجمه پردازش میکند. پیشتر، در واحد تحقیقات و توسعه ترجمه گوگل، موفقیت آموزش چندزبانه برای زبانهای دچار کمبود داده در این موارد به اثبات رسیدهاست:

- تشخیص خودکار گفتار (automatic speech recognition)

- سیستمهای تبدیل متن به گفتار (text-to-speech)

- ترجمه چندزبانه (multilingual translation)

پیشتر تأثیر افزایش تعداد زبانهایی که میتوانند در یک شبکۀ عصبی واحد (Single) یاد گرفته شوند را با در نظر داشتن حجم دادههای ورودی روی هر زبان بررسی میکردیم. اما وقتی تمام محدودیتها از بین بروند چه اتفاقی میافتد؟ آیا میتوانیم با استفاده از تمامی دادههای موجود، و بهرغم تفاوتهای گسترده میان زبانها از نظر حجم دادهها، اسکریپتها، پیچیدگی و دامنهها، مدلی واحد را آموزش بدهیم؟ (یا اینکه یک مدل واحد کافی نیست و به مدلهای متعدد نیاز است.)

در مقالۀ «ترجمۀ ماشینی عصبی بهشدت چندزبانه در شرایط طبیعی (خارج از محیط آزمایشگاهی): یافتهها و چالشها» و مقالات بعدی، با آموزش دادن یک مدل واحد NMT بهوسیلۀ بیش از 25 میلیارد جفت جمله، از بیش از 100 زبان [ترجمهشده] از و به انگلیسی، دارای بیش از 50 میلیارد پارامتر، بر محدودیتهای تحقیق روی NMT غلبه میکنیم. نتیجه، دستیابی به رویکردی برای ترجمۀ ماشینی عصبی گسترده و بهشدت چندزبانه (massively multilingual, massive neural machine translationM4) است که از ارتقای شدید کیفیت برای زبانهای دارای منابع کم و زیاد خبر میدهد و بهراحتی میتواند با تکتک دامنهها یا زبانها سازگار شود، و، در عین حال، روی وظایف انتقالی بینزبانی فروسو هم تأثیر زیادی دارد. (برای درک مفهوم وظایف فروسو Downstream Tasks در پردازش زبان طبیعی به این پرسش و پاسخ مراجعه کنید.)

ترجمۀ ماشینی بهشدت چندزبانه

اگرچه توزیع نامتقارن دادهها در بین جفت زبانهای مختلف مشکل بزرگی در اِناِمتی محسوب میشود؛ اما، همین توزیع نامتقارن سناریوی ایدهآلی را برای مطالعۀ انتقال ایجاد میکند. در این سناریو، میتوان آگاهی کسبشده در آموزش یک زبان را برای ترجمۀ سایر زبانها به کار برد. در یک سر نمودار توزیع، زبانهای پرمنبعی مانند فرانسوی، آلمانی و اسپانیایی وجود دارند، که میلیاردها مثال موازی در آنها به چشم میخورد، در حالی که، در سر دیگر آن، حجم دادههای تحت نظارت برای زبانهای کممنبعی همچون یاروبا، سندی و هاوایی به چند ده هزار مثال محدود میشود.

پس از آموزش دادن با استفاده از تمامی دادههای موجود (بیش از 25 میلیارد مثال از 103 زبان)، شاهد انتقال مثبت شدید به سمت زبانهای کممنبع بودیم، که باعث شد کیفیت ترجمۀ بیش از 30 زبان موجود در قسمت دُم نمودار توزیع بهطرزی چشمگیر و بهطور میانگین 5 نمرۀ بلو (نمره جایگزین ارزشیابی دوزبانه یا Bilingual Evaluation Understudy) ارتقا یابد.

اگرچه با توجه به تحقیقات قبلی ما این میزان تأثیر از قبل قابل پیشبینی بود اما این نتیجه فوقالعاده نویدبخش است. در نظر بگیرید که، مقایسه بین مبانی دوزبانه (یعنی مدلهایی که فقط با استفاده از جفت زبانهای مشخص آموزش داده شده بودند) و مدل چندزبانۀ واحدی انجام شد که ظرفیت بازنمود آن مشابه یک مدل دوزبانه بود. این یافته حاکی از آن است که مدلهای بهشدت چندزبانه قابلیت تعمیم دارند و میتوانند شباهت زبانهای متعدد را به ما نشان دهند.

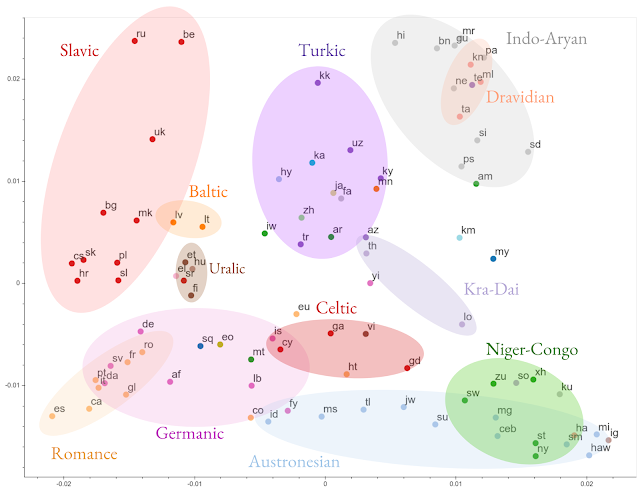

در مقالۀ EMNLP’19 خودمان [5]، بازنمودهای مدلهای چندزبانه را در میان زبانهای مختلف مقایسه میکنیم. درمییابیم که مدلهای چندزبانه بازنمودهای مشترک زبانهایی را که دارای مشابهتهای زبانشناختی هستند بدون نیاز به قیود بیرونی یاد میگیرند، و این امر بر درستی دانستههای شهودی دیرینه و نتایج تجربیای صحه میگذارد که از چنین شباهتهایی بهره میبرند. در مقالۀ شمارۀ 6، تأثیرگذاری این بازنمودهای یادگرفتهشده روی انتقال بینزبانی در عملیات فروسو را بیشتر نشان میدهیم.

ساخت شبکههای عصبی گسترده

با افزایش تعداد زبانهای کممنبع در مدل، کیفیت زبانهای پرمنبع شروع به کاهش میکند. این پسرفت در وضعیتهای چندوظیفهای دیده میشود و ناشی از رقابت بین وظیفه و ماهیت یکطرفۀ انتقال (یعنی از زبانهای پرمنبع به سمت زبانهای کممنبع) نشأت میگیرد. ما در عین حال که روی الگوریتمهای بهتر برای یادگیری و کنترل ظرفیت کار میکنیم تا این انتقال منفی را کاهش دهیم، با بزرگتر کردن شبکههای عصبیمان از طریق افزایش پارامترهای مدل، ظرفیت بازنمودی این شبکهها را بالا میبریم تا کیفیت ترجمه برای زبانهای پرمنبع کاهش پیدا نکند(ظرفیت بازنمودی representational capacity نشانگر انعطاف شبکه است) .

متنی که در حال مطالعه آن هستید، نمونهای از ترجمه متون تخصصی رشته کامپیوتر در سایت ترجمه شبکه مترجمین ایران است. شما نیز میتوانید با ثبت آنلاین سفارش، ترجمه متون تخصصی این رشته و رشتههای دیگر را به ما بسپارید.

برای بالا بردن ظرفیت شبکۀ عصبی از طرحهای مختلفی میتوان استفاده کرد؛ طرحهایی همچون افزودن لایههای بیشتر یا تعریض بازنمودهای مخفی. با پیگیری تحقیقاتمان دربارۀ آموزش دادن شبکههای عمیقتر برای ترجمه، از جیپایپ (GPipe) کمک گرفتیم تا ترانسفورمرهای (Transformer) 128 لایهای دارای بیش از 6 میلیارد مؤلفه را آموزش دهیم. افزایش ظرفیت مدل منجر به ارتقای چشمگیر و بهطور میانگین 5 نمرهای عملکرد در تمامی زبانها شد. ما سایر ویژگیهای شبکههای بسیار عمیق را نیز بررسی کردیم؛ ازجمله:

- موازنه میان عمق و عرض

- چالشهای آموزشپذیری

- طرحهای قابل انتخاب برای افزایش ظرفیت ترانسفورمرها به بیش از 1500 لایه و 84 میلیارد پارامتر

در حالی که افزایش عمق یکی از راههای افزایش ظرفیت مدل است، بررسی معماریهایی که میتوانند از ماهیت چندوظیفۀ مسأله بهره ببرند نیز روشی مکمل و فوقالعاده عملی محسوب میشود. با اصلاح معماری ترانسفورمر از طریق جایگزینی لایههای وانیلا و فیدفوروارد با لایههای جدید به نام sparsely-gated mixture of experts، ظرفیت مدل M4 را بهطرز شگرفی بالا میبریم. این کار باعث میشود بتوانیم 50 میلیارد مؤلفه را با موفقیت آموزش دهیم و پشت سر بگذاریم و کیفیت کل زبانها را افزایش دهیم.

عملی کردن مدل M4

آموزش دادن مدلهای بزرگ با هزینههای رایانشی بسیار بالا برای هر زبان، دامنه یا وظیفه انتقال روشی ناکارآمد است. در عوض، ما در آینده مدل M4 روشهایی ارائه میدهیم تا با استفاده از لایههای با ظرفیت قابل تنظیم این مدلها را عملیتر کنیم. استفاده از این لایهها سازگاری مدل با زبانها یا دامنههای جدید بدون تغییر شکل اولیۀ آن را ممکن میسازد.

گامهای بعدی

دستکم نیمی از 7000 زبانی که در حال حاضر صحبت میشوند در پایان قرن حاضر دیگر وجود نخواهند داشت*. آیا ترجمۀ ماشینی چندزبانه میتواند منجی این زبانها شود؟ ما رویکرد M4 را نخستین گام برای حرکت به سوی نجات دادن 1000 زبان بعدی میدانیم؛ آغاز کردن از اینگونه مدلهای چندزبانه ما را قادر خواهد ساخت تا، حتی در صورت عدم وجود دادههای موازی، بهراحتی به سراغ زبانها، دامنهها یا وظایف فروسوی دیگر برویم. مسلماً جاده ناهموار است و، در مسیر حرکت به سوی ترجمۀ ماشینی جهانشمول، چنین مینماید که بسیاری از راهکارهای احتمالی راهکارهایی میانرشتهای هستند. احتمالاً، این امر ترجمۀ ماشینی عصبی چندزبانه را به آزمونگاهی برای فعالان و نظریهپردازان حوزۀ یادگیری ماشینی تبدیل میکند که به بررسی پیشرفتهای مباحث دیگری در این حوزه مثل یادگیری چندوظیفهای، فرایادگیری، آموزش دینامیکهای شبکههای عمیق و … علاقه دارند. هنوز راه زیادی در پیش داریم.

* The Cambridge Handbook of Endangered Languages (Austin and Sallabank, 2011).